Aliruto

Let Freedom Reign

Je t’ai mis le lien plus haut.

je lis quand même que les 2+6x2 supportent 225w et non plus 150w à l’ancienne.

je lis quand même que les 2+6x2 supportent 225w et non plus 150w à l’ancienne.

Avec un GPU consommant grand max 475W ça pourrait aller, uniquement pour les alim ATX 3.X16/18 awg vu que j’en ai 2 comme ça (ici ce sont les câbles tresses en suppléments )

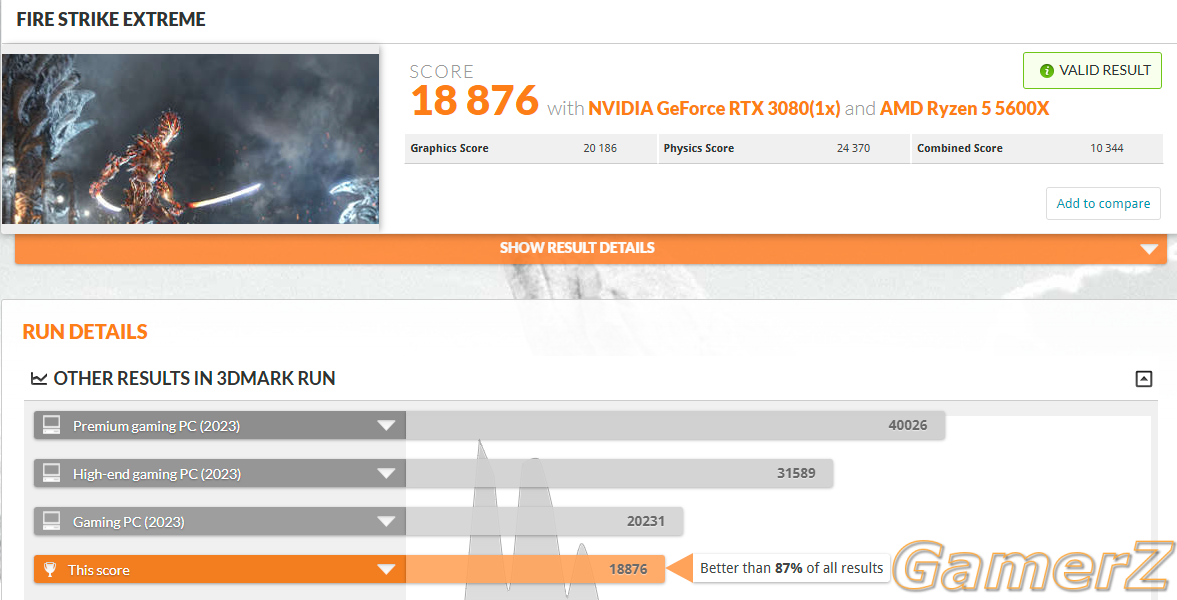

En tout cas ma 3080 fonctionne encore à merveille en 3440, bon je dois faire des réglages pour avoir 80/90 fps dans mes jeux, grâce au mod FG par exemple ou au lossless scalingÇa fait 4 ans que je lis que la 3080 10Gb est une merde mais 4 ans plus tard elle est toujours devant la 6800XT dans les derniers jeux : Stalker 2, Dragon age, Silent Hill 2, God of War. Warhammer, Black Myth

La 6900XT semble aussi se faire battre

II y a que des Call of duty dernièrement où AMD est devant, voir peut être final fantasy selon la résolution

En tant que possesseur d’une 6800XT j’ai l’impression de m’être fait avoir finalement

https://www.techpowerup.com/review/?category=Game+Testing&manufacturer=&pp=25&order=date

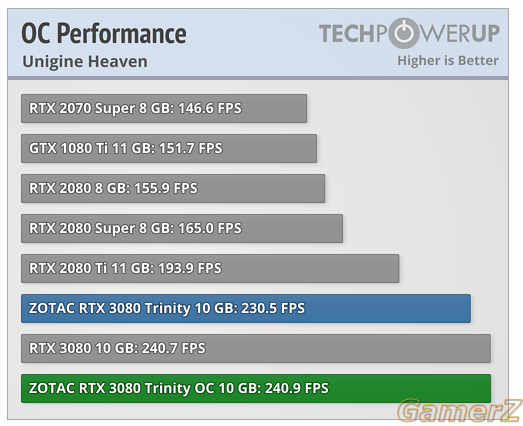

Ne me parlez pas d’OC. Ça m’intéresse pas et les performances doivent être mesurées comme la carte sort du constructeur

Attention c'est uniquement valable quand tu as une ALIM ATX 3.X de bonne qualitéBah je vois que les grosses xtx on est sur 350w +- donc effectivement pas de souci pour mettre du 3x8pin sur 2 câbles pcie en 6+2 x3

Je n'ai jamais comparé la 3080 10GB à un GPU AMD dans ce cas-ci.Ça fait 4 ans que je lis que la 3080 10Gb est une merde mais 4 ans plus tard elle est toujours devant la 6800XT dans les derniers jeux : Stalker 2, Dragon age, Silent Hill 2, God of War. Warhammer, Black Myth

La 6900XT semble aussi se faire battre

II y a que des Call of duty dernièrement où AMD est devant, voir peut être final fantasy selon la résolution

En tant que possesseur d’une 6800XT j’ai l’impression de m’être fait avoir finalement

https://www.techpowerup.com/review/?category=Game+Testing&manufacturer=&pp=25&order=date

Ne me parlez pas d’OC. Ça m’intéresse pas et les performances doivent être mesurées comme la carte sort du constructeur

Ne me parlez pas d’OC. Ça m’intéresse pas et les performances doivent être mesurées comme la carte sort du constructeur

be quiet! Pure Power 12 M 850W - Alimentation modulaire 80+ Gold ATX 3.0 PCIe 5.0 12VHPWRAttention c'est uniquement valable quand tu as une ALIM ATX 3.X de bonne qualité

& encore, seasonic recommande toujours d'utiliser 3 câbles pour du 3*8pin, ce qui est normal car ça répartit mieux la charge : p

Après quand tu overclock pas énormément c'est bon

Je n'ai jamais comparé la 3080 10GB à un GPU AMD dans ce cas-ci.

Mes 2080 Ti atomise les + puissante 3080 10GB tout en ne consommant que 100W de + ... (a la portée de tout le monde)

Sinon techpowerup test les gpu au tdp de ref avec un gpu de ref sans aucun OC.

Si vous vous intéressiez un minimum à ce que vous achetez, tu serais pas là à dire "j'ai l'impression de m'être fait avoir finalement".

J'ai vraiment l'impression que certains ici vous le faites exprès a faire semblant de pas comprendre ce que je dis.

Ou alors vous êtes des ignorants mais alors dans ce cas, pourquoi parler de choses qui vous sont inconnue, pourquoi ??? (a ce moment là faut poser des questions, pas écrire des "affirmations" à la con)

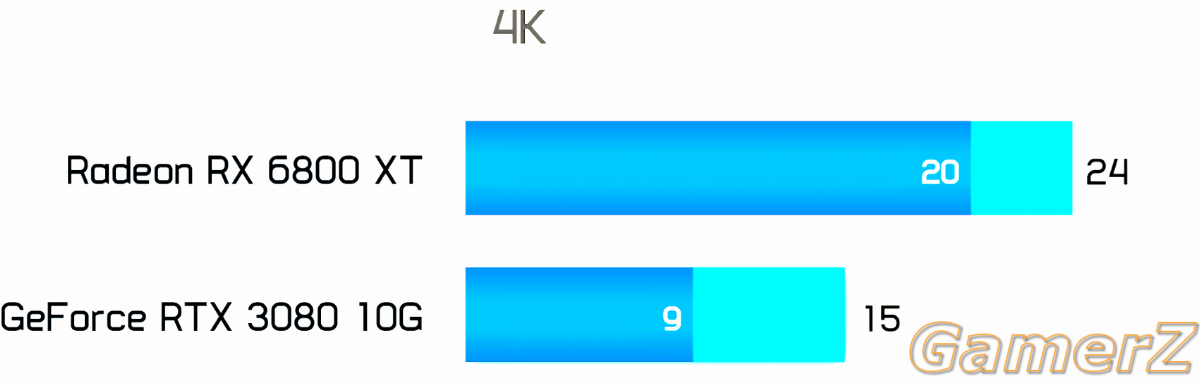

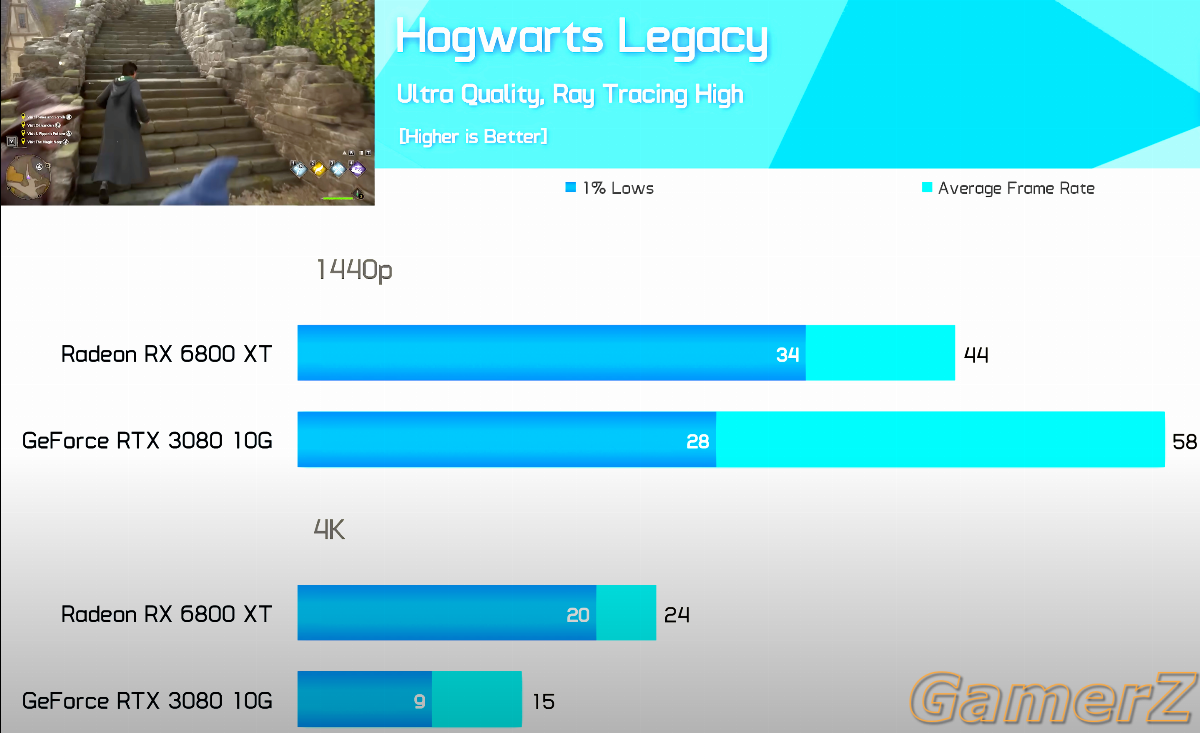

Je vais pas tout link hein mais la 6800 XT atomise la 3080 10G dans pleins de jeux en 4K.

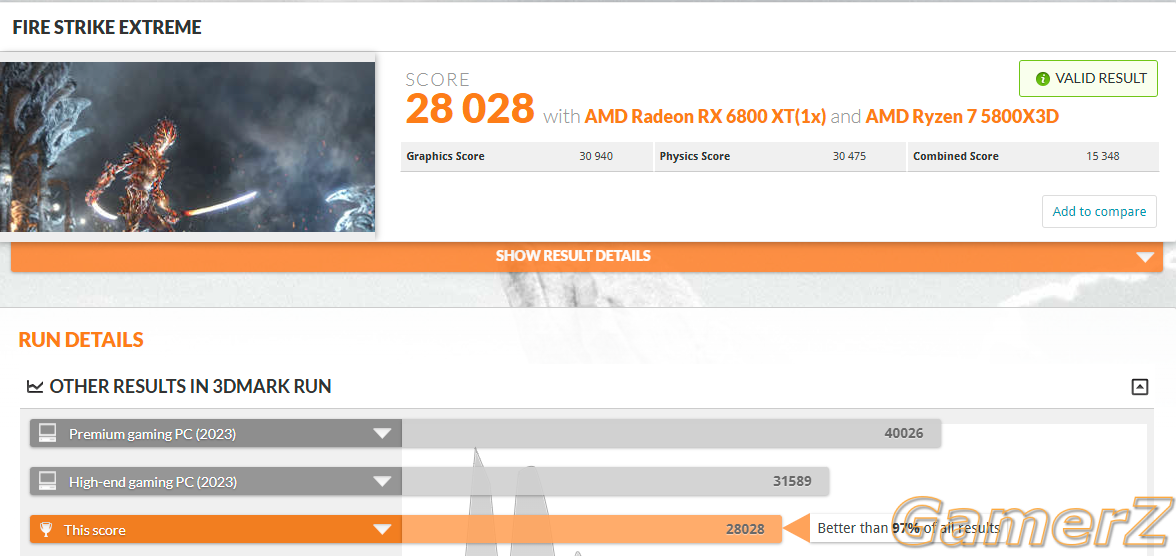

Voir la pièce jointe 123863

Hogwart 4K RT ... parfaitement jouable avec FSR 2 et AFMF2 sur la 6800 XT, injouable sur la 3080.

Diablo 4 ..., paramètre ultra avec pack ultra désactivé sur la 3080 10GB (injouable), + de 60fps sur la 6800 XT.

WoW en résolution supérieur au 4K et pas mal d'addons graphique... avec tout au max tu pleures en raid @6fps. (~12GB vram utilisé sur une 3080 12GB ..., injouable sur la version 10GB)

Pleins de jeux sont ainsi à cause du manque de vram et ça va faire qu'augmenter ...

Genre ils ont delete la 3080 10GB et l'ont remplacé par la 3080 12GB pour rien ?(Les 3080 12GB que j'ai, sont des monstres comparé aux 3080 10GB devenue obsolete, et pour le coup + puissante que mes 2080 Ti)

Suffit de stream en même temps ou d'avoir des app qui utilisent de la vram en arrière plan pour que ça rende énormément de jeux INJOUABLE. (évidemment ce que ne test JAMAIS des sites comme TPU)

Et oui il y a pas que les jeux qui utilisent de la vram, tout ce qui est affiché à l'écran ou même en arrière plan peut en utiliser ..., un navigateur peut très vite utiliser plus de 2GB.

En config multi écran avec un stream + une petite vidéo sur le côté c'est pire ...

Après t'es clairement l'acheteur type que les entreprises adorent

Viens pas dire que tu t'es fait avoir alors.

Tu sais que Nvidia overclock ces GPU au "max" par défaut ? (le nvidia boost c'est de l'overclock avec un lock du voltage, pour ça que depuis quelques années on ne gagne presque plus rien en perf en essayant d'aller encore plus loin sur un GPU Nvidia)

AMD à fait un peu comme Nvidia mais n'a pas totalement lock voltage & tdp.

Ils laissent le champ libre aux acheteurs (jusqu'a présent) ce qui fait qu'on a souvent des gains absolument monstrueux avec eux, comme les 7900 XTX @ 2900-3000mhz IG.

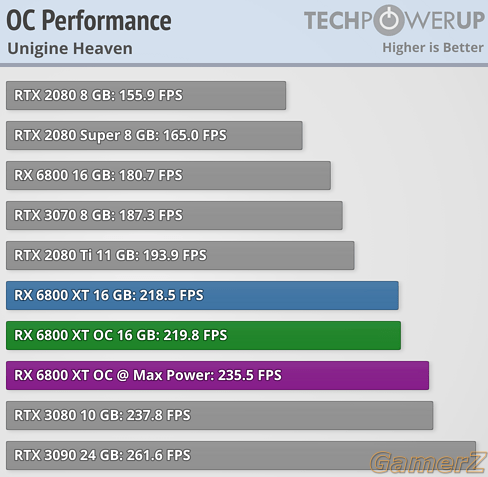

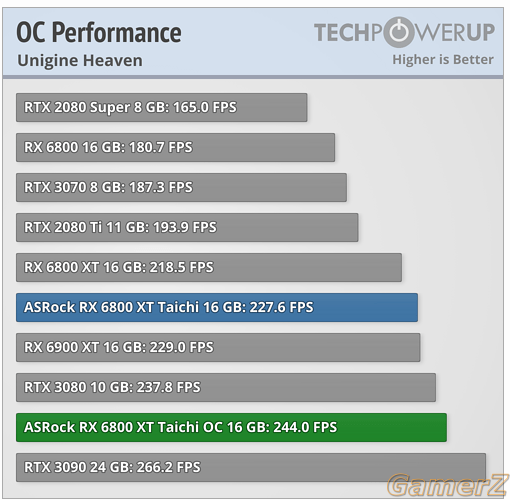

& la 6800 XT fait partie de ces GPU avec un potentiel monstrueux.

Tu pourrais même undervolt ton gpu et modifier un peu la courbe des mhz pour gagner énormément en perf ...

J'aime bien TPU mais c'est pas sur ce genre de sites qu'on voit la vraie puissance des GPU. (et ne parlons pas de leurs overclock éclaté au sol souvent effectué en quelques minutes)

Du coup je te conseil d'acheter la RTX 5080

& si l'oc/tune t'intéresse pas, arrête d'intervenir après que j'aie poster qqch au niveau des perfs, ça n'a aucun fucking sens.

Tu vas pas me faire croire que tu pensais que je parlais d'une 7900 XTX de ref avec un boost ridicule vs la RTX 4090 plus haut ?

Une fois de plus tu vas chercher les benchs qui t'arrangent.Attention c'est uniquement valable quand tu as une ALIM ATX 3.X de bonne qualité

& encore, seasonic recommande toujours d'utiliser 3 câbles pour du 3*8pin, ce qui est normal car ça répartit mieux la charge : p

Après quand tu overclock pas énormément c'est bon

Je n'ai jamais comparé la 3080 10GB à un GPU AMD dans ce cas-ci.

Mes 2080 Ti atomise les + puissante 3080 10GB tout en ne consommant que 100W de + ... (a la portée de tout le monde)

Sinon techpowerup test les gpu au tdp de ref avec un gpu de ref sans aucun OC.

Si vous vous intéressiez un minimum à ce que vous achetez, tu serais pas là à dire "j'ai l'impression de m'être fait avoir finalement".

J'ai vraiment l'impression que certains ici vous le faites exprès a faire semblant de pas comprendre ce que je dis.

Ou alors vous êtes des ignorants mais alors dans ce cas, pourquoi parler de choses qui vous sont inconnue, pourquoi ??? (a ce moment là faut poser des questions, pas écrire des "affirmations" à la con)

Je vais pas tout link hein mais la 6800 XT atomise la 3080 10G dans pleins de jeux en 4K.

Voir la pièce jointe 123863

Hogwart 4K RT ... parfaitement jouable avec FSR 2 et AFMF2 sur la 6800 XT, injouable sur la 3080.

Diablo 4 ..., paramètre ultra avec pack ultra désactivé sur la 3080 10GB (injouable), + de 60fps sur la 6800 XT.

WoW en résolution supérieur au 4K et pas mal d'addons graphique... avec tout au max tu pleures en raid @6fps. (~12GB vram utilisé sur une 3080 12GB ..., injouable sur la version 10GB)

Pleins de jeux sont ainsi à cause du manque de vram et ça va faire qu'augmenter ...

Genre ils ont delete la 3080 10GB et l'ont remplacé par la 3080 12GB pour rien ?(Les 3080 12GB que j'ai, sont des monstres comparé aux 3080 10GB devenue obsolete, et pour le coup + puissante que mes 2080 Ti)

Suffit de stream en même temps ou d'avoir des app qui utilisent de la vram en arrière plan pour que ça rende énormément de jeux INJOUABLE. (évidemment ce que ne test JAMAIS des sites comme TPU)

Et oui il y a pas que les jeux qui utilisent de la vram, tout ce qui est affiché à l'écran ou même en arrière plan peut en utiliser ..., un navigateur peut très vite utiliser plus de 2GB.

En config multi écran avec un stream + une petite vidéo sur le côté c'est pire ...

Après t'es clairement l'acheteur type que les entreprises adorent

Viens pas dire que tu t'es fait avoir alors.

Tu sais que Nvidia overclock ces GPU au "max" par défaut ? (le nvidia boost c'est de l'overclock avec un lock du voltage, pour ça que depuis quelques années on ne gagne presque plus rien en perf en essayant d'aller encore plus loin sur un GPU Nvidia)

AMD à fait un peu comme Nvidia mais n'a pas totalement lock voltage & tdp.

Ils laissent le champ libre aux acheteurs (jusqu'a présent) ce qui fait qu'on a souvent des gains absolument monstrueux avec eux, comme les 7900 XTX @ 2900-3000mhz IG.

& la 6800 XT fait partie de ces GPU avec un potentiel monstrueux.

Tu pourrais même undervolt ton gpu et modifier un peu la courbe des mhz pour gagner énormément en perf ...

J'aime bien TPU mais c'est pas sur ce genre de sites qu'on voit la vraie puissance des GPU. (et ne parlons pas de leurs overclock éclaté au sol souvent effectué en quelques minutes)

Du coup je te conseil d'acheter la RTX 5080

& si l'oc/tune t'intéresse pas, arrête d'intervenir après que j'aie poster qqch au niveau des perfs, ça n'a aucun fucking sens.

Tu vas pas me faire croire que tu pensais que je parlais d'une 7900 XTX de ref avec un boost ridicule vs la RTX 4090 plus haut ?

Non mais arrete de nous sortir des screens de TPU effectué avec la V1.0 des jeu et PLUS JAMAIS maj ensuiteUne fois de plus tu vas chercher les benchs qui t'arrangent.

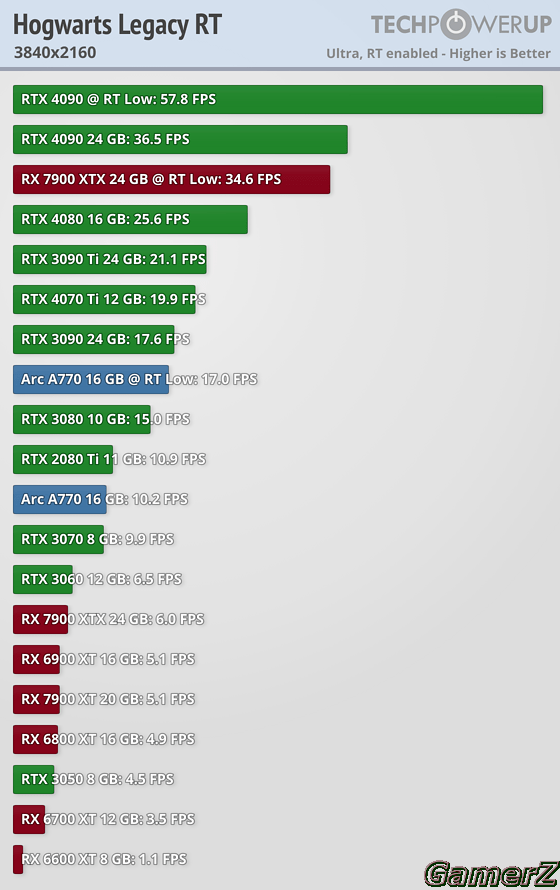

Je peux aussi aller chercher un bench qui m'arrange au hasard : Hogwart 4K RT

Voir la pièce jointe 123866

Je pourrais même sortir des phrases ridicules dont tu as le secret comme : la 3070 8GB atomise la 7900XTX 24GB de presque 70%

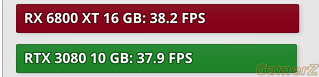

On fera coucou à la 2080 TI qui atomise la 3080 10Go au passage

Et tu fais passer les personnes qui ne veulent pas/plus se prendre la tête pour des pigeons ignares parce qu'ils ont pas envie d'aller jouer avec l'overclocking de leur carte ou aller acheter un soft à un développeur ukrainien sur un Patreon. La condescendance du PC Master Race dans le mille

Il est normal que les cartes soient testé comme elles sortent du constructeur, encore mieux c'est si c'est le modèle de référence. Je vois pas pourquoi les sites de review devraient commencer à OC toutes les cartes testés. Le but est d'avoir le résultat que chaque consommateur aura selon les spécifications que le constructeur lui à donné.

ça fait 4 ans que nous rabâche que la 3080 10Go est une merde et que la 6800XT l'atomise

Finalement l'histoire que tu nous racontes que c'est la 6800 XT Custom (pas ref attention) avec OC/Tune est parfois supérieure à la 3080 10GO dans certains jeux à une certaine résolution avec FSR 2 et AFMF2

Tu prends ce qui t'arrange pour allègrement chier en boucle sur Nvidia, parce que tu as décidé il y a quelques années que tu les aimais pas, alors qu'au final et dans la majorité des derniers jeux sortis la 3080 10Go est exploitable et plus performante qu'une 6800/6900XT par défaut.

Même si les 10Go n'était clairement pas le choix idéal, la carte n'est pas la merde décrite dans tes posts. Quitte a critiquer Nvidia tu peux boucler sur leur connecteur qui prend feu ou les pcb qui craquent, les prix.

, tu n'y connais rien en OC/tune et encore moins en GPU.

, tu n'y connais rien en OC/tune et encore moins en GPU.

?

?Faux, en plus tu dis n'importe quoi, car la totalité des sites depuis la nuit des temps teste l'overclock, basique certes mais un overclock quand même.Il est normal que les cartes soient testé comme elles sortent du constructeur, encore mieux c'est si c'est le modèle de référence. Je vois pas pourquoi les sites de review devraient commencer à OC toutes les cartes testés. Le but est d'avoir le résultat que chaque consommateur aura selon les spécifications que le constructeur lui à donné.

(ils se battent tous pour release leurs soft amélioré à chaque release de GPU ...sauf que MSI Afterburner est le meilleur)

(ils se battent tous pour release leurs soft amélioré à chaque release de GPU ...sauf que MSI Afterburner est le meilleur)

Non rien avoir, hogwart était bugué en V1 sur ses screens.Peut-être @artysm que ton test n'inclus par le fsr2 u afmf2 vu que vous êtes iso niveau fps de la 3080 ?

Allé, je t'en supplie ignore moi si c'est pour continuer ainsi.C’est évidemment clair, comme il n’y a pas de dlss ou autre

J’ose espérer qu’on parle pas d’un jeu parfaitement jouable à 24 fps (quand ça drop pas à 20 fps) de moyenne avec FSR 2 et afmf2

EDIT : Ceci dit je dirais qu'il y a un problème sur le bench de techpowerup avec Hogwarts Legacy et les cartes AMD en RT mais c'était pour prouver qu'on peut faire dire n'importe quoi à un bench en particulier, mais si tu commences à regarder sur un ensemble de jeux, la réalité se trouve plutôt là.

C'est peine perdue....j'ai abandonné depuis un certain temps.

Tu as essayé iracing avec un triple screen?C'est peine perdue....j'ai abandonné depuis un certain temps.

Je suis convaincu maintenant ..... j'ai mm revendu ma 4090 pour une 7900xtx qui atomise tout...

bonne journée

Regarde le message en dessous du tiens.

, alors 10GB pour du 1440P/4K...)

, alors 10GB pour du 1440P/4K...)

Je pense l’avoir fait mais je suis peut-être trop teubé et je m’en suis pas rendu compte

Ce sera mon dernier message là dessus, de toute façon vu tes messages tu t'en fous je pense.Je pense l’avoir fait mais je suis peut-être trop teubé et je m’en suis pas rendu compte

J’arrête vu que je connais rien visiblement, je suis un malade t’entends

)

)

c'est surtout que par écrit, tu n'as aucune appréciation de comment c'est dit.Bah ça sert a rien de rendre minable tout les aspects de votre vie ou de la sienne sur une discussion sterile de performance hardware