La France n'est historiquement pas un pays de gauche me semble-t-il.

Je n'irais pas jusque là. Ils avaient leurs grands mouvements communistes.

De plus, c'est un État assez social, où il a été question de classes, des travailleurs, etc.

La France possède une grande bourgeoisie, et des luttes sociales ont effectivement été gagnées par "la droite".

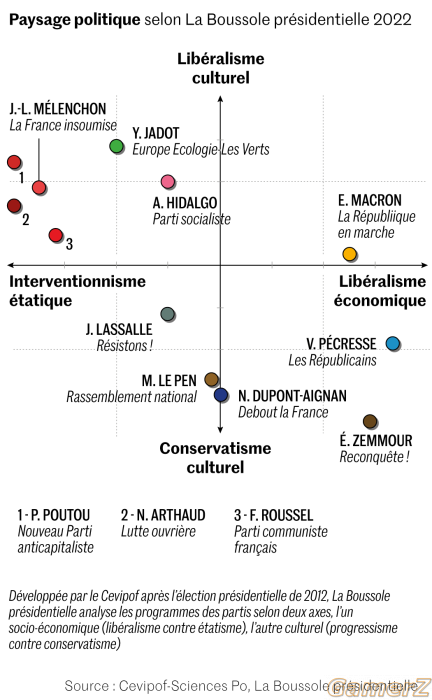

Maintenant, c'est un concept difficile car on ne sait jamais comment la personne le définit et ce qu'elle comprend en utilisant ces mots.

D'ailleurs, les définitions ont changé avec le temps. Avant, le libéralisme était de gauche (et l'est tjs au USA, dans une certaine mesure).

Maintenant, il y a une récupération conservatrice du libéralisme et une réduction de sa définition au courant politique et économique "ultra" et est donc devenu un "concept" de droite.