Arrête stp. Il ne changera pas, lisez ses posts en conséquence et arrêtez d'être trigger à chaque fois pcq "ça vous heurte votre ego" ou que sais-je d'autre.

Au milieu de son style un peu relou (mais qui ne changera pas), il donne des infos intéressantes, je me limite à ça, je vous conseille d'en faire de même.

Je ne vois plus ces messages & je lui avais déjà demandé de ne plus me lire

(& j'ai été au delà de la fonction ignorer de gamerz ce qui m'empêche de voir ses posts vu que je n'ai plus le petit message "afficher le contenu ignoré"

)

Ce qui est marrant c'est que sur des forums spécialisé où je suis ... (Anglais, Russe & Allemand), absolument personne agit comme lui : p

Là bas j'ai même vendu des 3080 20GB directement, absolument pas la volonté de le faire ici (mais ça c'est aussi à cause de la section achat/vente ...), c'est triste hein.

(Je connais un revendeurs chinois qui vend des 3080 20GB pour à peine 370€ frais inclus (100% fonctionnel ingame & perf de malade))

Je peux aussi avoir des 4090 48GB pour ~1800€

(plus pour l'IA à la base mais fonctionne IG aussi)

Pas mal de personnes qui ont switch de la 7900 XTX vers la 5080 regrettent, on en rigole et ça se passe très bien (surtout sur overclocker.net : p ).

Ils sont pas là à parler de leurs fps et à essayer de dire que si que là ... pour défendre leurs gpu/achat, c'est tout le contraire

(je voudrais pas lire les messages si j'étais un employé de Nvidia)

Ici on a l'impression que vous protéger vos achats, c'est fou.

---

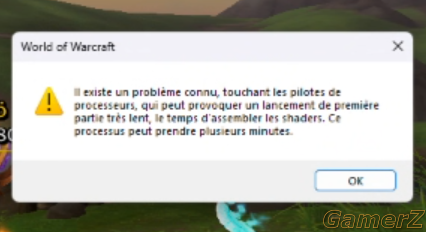

Sinon pour info, si vous avez une RTX avec 12GB ou moins, vous verrez peut-être parfois ce message :

(traduction foireuse, ça fait bien référence au gpu et pas au processeur, ça n'a rien avoir avec le message concernant les CPU intel

)

C'est normal; Nvidia ne voulant pas corrigé le "problème" d'assemblage des shaders, les dev ont créer ce message (pas que sur wow).

En soit c'est pas grave mais si vous lancez un jeu rapidement sans attendre, vous pouvez avoir ~10fps au début. (on reçoit bcp de tickets sur le sujet ...)

Le même message peut apparaitre sur les 5060 TI 8GB & 5070 12GB.

Je mets ça ici comme j'ai eu plusieurs membres de ma guilde qui ont eu le message et pensaient avoir un problème ...

Peut-être que j'ai inventé ce problème de shaders sur les RTX, qui sait ?

(les dev de wow qui mentent aussi peut-être ? )

Parfois, j'ai l'impression que la VRAM est devenue une sorte d'obsession. Certains ne jurent que par elle, comme si c'était l'unique facteur de performance, alors qu'on parle ici de GPU qui ont presque cinq ans. À l'époque de leur sortie, ces cartes ont été pensées, conçues et surtout "marketées" pour les jeux du moment, pas pour ceux à venir cinq ans plus tard avec des moteurs toujours plus gourmands.

Je ne dis pas que la VRAM ne joue aucun rôle, bien sûr qu'il y a des exceptions, surtout dans les jeux récents avec textures ultra ou RT activé. Mais encore une fois, j'ai du mal avec les discours très arrêtés, qui manquent de nuance et laissent peu de place à une vision globale. La puissance brute du GPU, le niveau d'optimisation des jeux, les réglages choisis, tout ça compte aussi, et souvent bien plus que 2 Go de VRAM en plus ou en moins.

Et puis, concernant l'obsolescence programmée, je pense que le sujet mérite d'être abordé avec un peu plus de subtilité. Oui, les constructeurs poussent à la consommation, c'est évident. Mais le matériel vieillit aussi naturellement : les moteurs évoluent, les jeux deviennent plus exigeants, les standards changent. On finit tous par devoir changer de matériel à un moment ou un autre, pas toujours parce que c'est voulu par les marques, mais simplement parce que la tech avance.

Voilà, c'était mon petit message dans le débat

???

& donc la RTX 3060 12GB qui peut utiliser des textures en ultra alors que les 3070/3080 ne peuvent pas ?

La 2080 Ti 11GB qui peut utiliser les textures en ultra alors que les 3070 Ti / 3080 / 4070 8-10GB ne peuvent pas ?

La 5060 Ti 16GB qui utilise les textures ultra sans problème quand la 5070 12GB à des drop plus élevé ?

La 3080 12GB qui atomise la 3080 10GB alors que les perf sont normalement identique & même à l'avantage de la version 10GB ?

Toi comme d'autres, ne semble avoir pas compris ou vous voulez ne pas comprendre ?

J'hallucine, des dizaines de vidéos ont été post par les meilleurs youtubers pour dénoncer ça et en parler, & ici c'est bisounours land, nvidia tout beau tout gentil avec des produits excellent ...

Bon bah je vais conseiller d'acheter les 5060 Ti 8GB & 5070 12GB dans ce cas, ça ne vaut clairement pas le coup de mettre un peu plus cher dans des gpu futureproof

N'oubliez pas l'excellente 9060 XT 8GB à venir aussi, AMD s'est dit que Nvidia ne devait pas être le seul à faire de la merde

. (& oui je suis pas fan de x ou y ...)

Le problème c'est pas de release ces produits mais de faire de la com autour en disant que ce sont d'excellent produits pour jouer ...

)

)

(les dev de wow qui mentent aussi peut-être ? )

(les dev de wow qui mentent aussi peut-être ? )

. (& oui je suis pas fan de x ou y ...)

. (& oui je suis pas fan de x ou y ...)