La règle du n>=30 est une règle très généraliste, et bien que ce soit souvent la règle que les étudiants retiennent de leur cours de stats, elle varie largement selon l'effet que tu veux tester,la précision que tu veux atteindre les variables cachées, ta méthode d'échantillonnage (random, cluster), etc.

A titre d'example, une même étude clinique ne va pas du tout demander la même taille d'échantillonnage si elle est en phase I, phase II, ou phase III. Un n=30 en phase II ou III sera sans doute souvent considéré comme trop faible. Dans un autre registre, lorsque l'ONU fait face à une catastrophe sanitaire ou alimentaire et doit évaluer le taux de mortalité dû à la malnutrition, ils estiment que le minimum sample size requis peut varier drastiquement et facilement demander un sampling de quelques centaines d'individu (formule trouvable sur unhcr.org). Ce n'est évidemment pas pareil que d'évaluer la mortalité suite à une infection virale, mais ça remet un peu dans le contexte le chiffre magique du "sample size >=30".

C'est une des questions question que tu dois te poser en commençant ton analyse. Le fait que tu dises "ici on était à 100" m'interroge un peu: que considères tu comme ton sample de départ, quelles hypothèses poses-tu, et que cherches tu à extrapoler ?

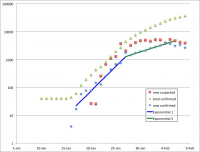

Je n'ai rien contre jouer avec les chiffres, je trouve même ça parfois très intéressant mais ici j'ai parfois l'impression que tu prends des datasets différents d'un jour à l'autre et que tu essayes de les raccorder à tout prix.